AI and cybersecurity

Analyser les domaines de la cybersécurité où l’Intelligence Artificielle permet des avancées

Catégorie : Groupe de travail Cycle : Cycle 2 Statut : En cours

Date de début : mai 2021

Date de fin : décembre 2023

Working Group objectives and deliverables

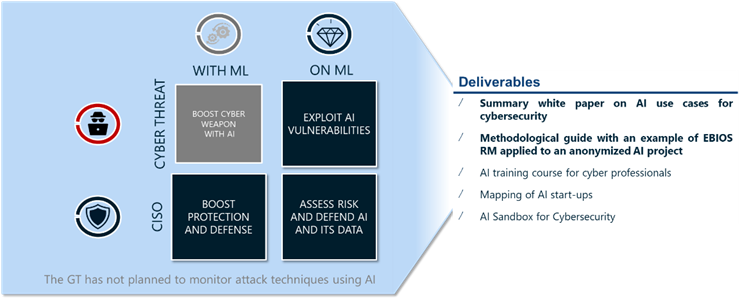

The mission of the Working Group, launched as part of Cycle 2 of the Cyber Campus, is to analyze the areas in which cybersecurity and artificial intelligence intersect.

Initial objectives

- Catalog the potential uses of AI for cybersecurity

- Create a CYLVIA sandbox environment enabling Cyber Campus members to experiment and evolve in a restricted environment.

- Create AI training courses for cybersecurity professionals at various levels.

- Identify and map startups specializing in AI solutions for cybersecurity.

- Identify cyberthreats and possible mitigations on AI application systems

The security of intelligent systems and their uses in cybersecurity, state of knowledge and skills

Artificial Intelligence systems are becoming more and more widespread in modern information technology, and have made many advances in recent years. With a view to preparing the next generations of applications and defense systems against cyber threats, the Cyber Campus, through the Artificial Intelligence and Cybersecurity Working Group, is highlighting the main uses of AI to benefit cybersecurity, the limits identified as well as the risks and main measures recommended for the security of these systems.

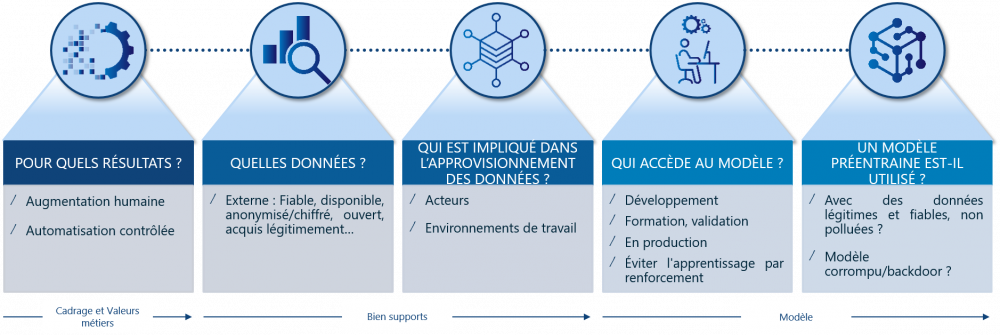

Which players are involved in Artificial Intelligence projects?

Artificial Intelligence projects involve a wide range of players in order to make the most of the data and respond to the use case identified in advance. Identifying key resources is a major challenge for any cybersecurity expert at the start of a project, and a succinct description of roles and responsibilities helps to quickly identify the stakeholders. The various phases of an AI project, including the development, production launch and monitoring of an AI application, involve many players, some of whom are data science specialists, others not. The diagram below shows the four main families of players identified:

- "Business" profiles, in charge of the use case and its validation in relation to the company's objectives;

- Data science specialists, in charge of implementing Artificial Intelligence techniques to meet the needs identified by the "business";

- IT profiles, in charge of developing and putting into production the use cases designed by the data science specialists;

- Risk profiles, in charge of monitoring and ensuring compliance with internal policies and external regulations.

It should be noted that each company may have slightly different names for these profiles, and may even divide the roles between different players in different ways. Some of these profiles are cross-functional and work on numerous projects (business sponsor, production platform administrator, data architect and risk profiles), while others are dedicated to a single project and form a project team. Risk profiles must therefore work alongside AI profiles in mixed project teams.

The Working Group also recommends the creation of two complementary positions, référents sécurité en Intelligence Artificielle and Facilitateurs en Intelligence Artificielle.

What contribution can artificial intelligence make to cybersecurity?

Intelligence Artificielle, as a scientific field, has benefited from numerous advances over the last few years, notably thanks to the pooling of techniques, capabilities and data enabling the use of statistical Machine Learning approaches to the detriment of deterministic Expert Systems approaches. This approach enables generalization and brings benefits when a significant amount of data is pooled to limit statistical effects. As a result, cybersecurity research is naturally focused on the following areas:

- Identification and localization of corporate information, starting with its classification, and the application of dynamic policies;

- Protection by analyzing weak signals and common behaviors, AI-based systems enable security policies and mechanisms to be configured as effectively as possible;

- Detection by analyzing the slightest variation in behaviors and changes to infrastructures to dynamically build detection scenarios;

- 'Recovery through decision support, with detailed knowledge of the information system, to establish the response and recovery strategy associated with a cybersecurity incident.

Based on the challenges and experiments carried out in a number of contexts, the Working Group has identified a set of cybersecurity use cases that can be accelerated or enhanced by the use of Artificial Intelligence. To this end, a framework has been defined to classify and enrich the use cases.

This Use Case Classification Framework is an initiative of the Working Group: it is based on guides and standards in the field, and is intended to be a "practical" way of simply categorizing use cases and encouraging the identification of new ones. In addition to helping to organize knowledge, this framework has been designed to facilitate sharing with international entities. It is built around three axes:

- categorization of use cases according to the activities of cybersecurity teams, following a typical cybersecurity organization breakdown;

- categorization of the use case according to the security objectives it seeks to address. The NIST Cybersecurity Framework is used here;

- reconciling the use case with the attack treatment of MITRE ATT&CK or the implementation of defense elements of MITRE D3FEND.

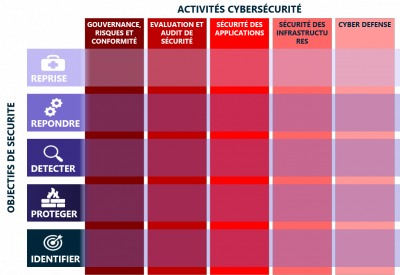

Cybersecurity activities

The categorization of use cases in relation to the activities of cybersecurity teams has resulted in 5 main categories:

- La gestion des risques et de la conformité, incluant l’ensemble des activités de définition, traitement et gestion des risques et régulations applicables aux organisations ;

- L’ évaluation de sécurité, souvent identifié au travail des « Red Teams », réalisant les activités d’audit, de tests d’intrusion, et de compromission de l’organisation ;

- La sécurité applicative, intégrant les domaines de la gestion des identités et des accès, la mise sous protection des applications (Security by Design, SDLC, DevSecOps, etc.) ;

- La sécurité des infrastructures, intégrant la mise en œuvre des solutions de cybersécurité d’infrastructure (FW, IPS, EDR, Proxy, Annuaires, etc.) nécessaires à la sécurité en profondeur des systèmes d’information ;

- Les activités de cyberdéfense, souvent identifié au travail des « Blue Teams », assurant la sécurité opérationnelle des Systèmes d’Information des organisations.

Objectifs de sécurité

Les objectifs de sécurité visent à déterminer les activités à mettre en œuvre afin de maîtriser les risques de cybersécurité au sein des organisations, ceux-ci sont découpés en 5 types selon le framework du NIST :

- IDENTIFIER ayant pour objectif l’identification, l’évaluation, et la mise en œuvre de l’organisation adaptée à la maîtrise du système d’information et au traitement des risques ;

- PROTÉGER ayant pour objectif de mettre en œuvre les activités nécessaires à la protection et au maintien en condition de sécurité des systèmes d’information ;

- DÉTECTER ayant pour objectif d’identifier et de qualifier les incidents de cybersécurité ;

- RÉPONDRE ayant pour objectif le traitement des incidents de cybersécurité : arrêt ou confinement de l’attaque, adaptation de la politique de sécurité ou de sa mise en œuvre ;

- REPRISE ayant pour objectif de retourner à un état de fonctionnement normal suite à un incident de cybersécurité.

Cas d’usages récences par les membres du Groupe de Travail Intelligence Artificielle et Cybersécurité

- Cas d'usage de Classification des données

- Cas d'usage d'utilisation du Machine Learning dans la mitigation d'attaque DDoS

- Cas d'usage de protection de la marque, lutte contre le typo-squatting

- Cas d'usage d'identification de démissionnaires pressentis

- Cas d'usage de User and Endpoint Behavior Analysis dans un SOC

- Cas d'usage de détection de man-in-the middle dans les réseaux OT et IoT

- Cas d'usage de User Behavior Anomaly Detection pour les comptes compromis

- Cas d'usage de contrôle des élévations de privilèges irrégulières

- Cas d'usage d'utilisation du pwnagotchi pour casser les WIFI

Quelles solutions pour sécuriser les applications utilisant des systèmes d'intelligence artificielles ?

Un système IA vu par les experts cybersécurité

nécessaire à la réalisation de tout projet IA, dans le cadre du Groupe de Travail, seules les briques communes ont été identifiées pour apporter une vision pragmatique et succinctes aux lecteurs.

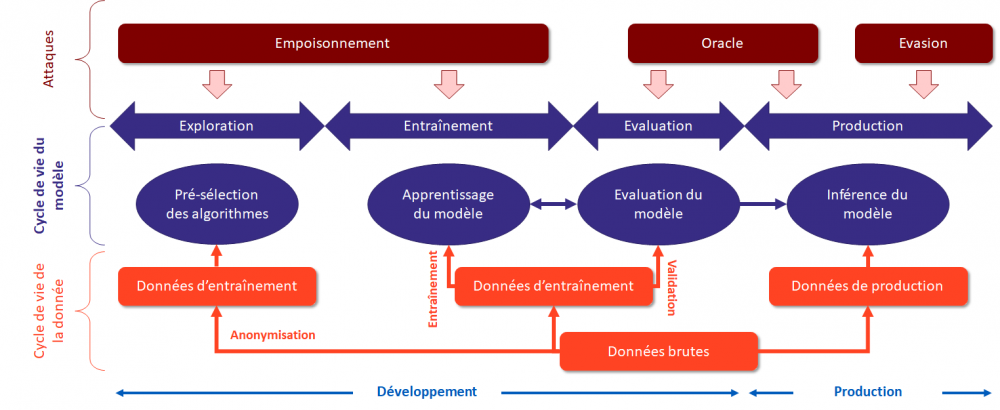

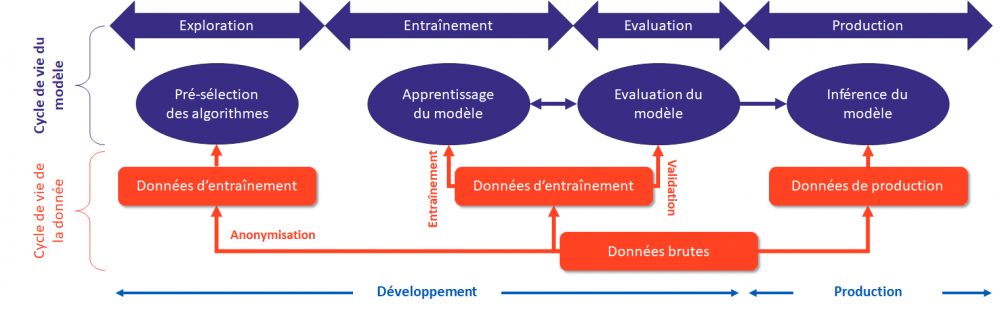

Un système d’Intelligence Artificielle peut être représenté suivant un pipeline composé de 4 étapes clés :

- L'Exploration est un ensemble de composants techniques permettant d'analyser des données pour en comprendre le sens et déterminer les axes d'analyse des phases suivantes ;

- L'Entraînement est un ensemble de composants techniques permettant de réaliser la modélisation des données et la réalisation de l'apprentissage d'un modèle d'IA ;

- L'Evaluation est un ensemble de composants techniques permettant de valider la pertinence d'un modèle entraîné par rapport aux objectifs visés par la modélisation ;

- La Production est un ensemble de composants techniques permettant au modèle d'inférer des résultats à partir de données de production.

Les attaques contre le ML peuvent être regroupés en 3 grandes familles (empoisonnement, oracle et évasion) et couvrent l’ensemble de cycle de vie d’un système à base de ML.

Les recherches du groupe de travail ont identifié différents 5 schémas d’attaques applicable à tout système d’Intelligence Artificielle :

- Attaque par empoisonnement des données d’entrainement (ciblé ou non)

- Attaque sur la chaîne d’approvisionnement des données – data supply

- Attaque sur la chaîne d’approvisionnement des bibliothèques – library supply

- Attaque par oracle sur le modèle en production

- Attaque par évasion sur le modèle en production

Des solutions concrètes permettent de réduire les risques de compromission des systèmes

Les 4 bonnes pratiques à mettre en place pour limiter les risques liés aux systèmes IA sont :

- Mettre en œuvre un comité éthique et risques pour sélectionner les cas d’usages intelligence artificielle pertinents pour l’entreprise et les données autorisées

- Informer les équipes intelligence artificielle et Data de leurs droits et devoirs pour manipuler les données et les risques associés

- Former les équipes intelligence artificielle et Data aux bonnes pratiques de manipulation sécurisée de la donnée (anonymisation, chiffrement…), aux techniques d’apprentissage distribué et au développement sécurisé

- Définir sur chaque projet : les données ne pouvant pas être transmises au système, les limites de déviation/pertinence du système acceptables et les signaux de vol de donnée (volume de requête, interrogation ciblée sur une donnée critique…)

Des mesures spécifiques aux environnements de développement, d’entraînement, de validation et de production :

- Standardiser l’anonymisation de la collecte des données, le chiffrement de leur stockage et de leur transmission

- Mettre en œuvre des scénarios de détection des fuites d’information pour l’ensemble du pipeline data

- Prévoir un environnement d’entraînement spécifique et isolé avec un accès restreint aux librairies pour ceux qui manipulent les jeux de données

- Valider régulièrement le niveau de sécurité des librairies et composants open-sources utilisés dans les environnements d’entraînement et de validation

- Construire des datasets adverses avec les scénarios de risques identifiés pour valider les changements sur les modèles

- Lancer les modèles en production dans des enclaves sécurisées ayant des droits d’exécution limités

- Surveiller les systèmes pour détecter les déviations

Communs

| Analyse des attaques sur les systèmes de l'IA | Production du livrable "Analyse des attaques sur les systèmes de l'IA" dans le cadre de la Communauté d'Intérêt Sécurité de l'IA co-piloté par le Campus Cyber et le Hub France IA |

| Appliquer EBIOS RM à un système IA | Application du guide « méthodologie EBIOS RM » publié par l’ANSSI pour évaluer un système à base d’intelligence artificielle. |

| Cas d'usage IA et Cybersécurité | Le groupe de travail IA et cybersécurité a identifié plusieurs cas d'usages, listés ci-dessous. |

| Facilitateur en Intelligence Artificielle | Un facilitateur IA est un correspondant cyber disposant de connaissances pratiques en cybersécurité et en Intelligence Artificielle. |

| L'intelligence artificielle en cybersécurité | Identifie et analyse certains cas d'usage où l’Intelligence Artificielle permet des avancées pour la cybersécurité. |

| Référent sécurité en Intelligence Artificielle | Le référent cybersécurité pour les data scientists est intégré dans leur environnement de travail. Il est leur point de contact privilégié pour assurer concrètement la prise en compte de la cybersécurité dans les projets IA qu’ils développent. |

| Réglementation de l'IA | Synthèse de la règlemention européen dite « Artificial Intelligence Act ». |

| UC3 : Brand protection, fight against typo-squatting | Développement du Use Case pédagogique "UC 3 : Lutte contre le typosquatting" dans le cadre du GT IA et Cyber |

| UC5 : Machine Learning vs DDoS | Développement du Use Case pédagogique "Machine Learning vs Attaque DDoS" dans le cadre du GT IA et Cyber |

| UC7 : Suspicious security events detection | Développement du Use Case pédagogique "Suspicious security events detection" dans le cadre du GT IA et Cyber |

Cas d'usage

| Statut | ||

|---|---|---|

| Confidentiality Classification | ||

| Lutte contre le typo-squatting |