« IA et cybersécurité » : différence entre les versions

Aucun résumé des modifications |

Cette version a été marquée à traduire |

||

| (59 versions intermédiaires par 7 utilisateurs non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

{{Groupe de travail | {{Groupe de travail | ||

|ShortDescription FR=Analyser les domaines de la cybersécurité où l’Intelligence Artificielle permet des avancées | |||

|ShortDescription=Analyser les domaines de la | |ShortDescription EN=Analyze the areas of cybersecurity where Artificial Intelligence can make a difference | ||

| | |ImageStr=MicrosoftTeams-image (2).png | ||

|StartDate=mai 2021 | |||

|StartDate=2021 | |EndDate=décembre 2023 | ||

|EndDate= | |||

|Cycle=Cycle 2 | |Cycle=Cycle 2 | ||

|Status= | |Status=Terminé | ||

}} | }} | ||

== | <translate> | ||

== Objectifs et livrables du Groupe de Travail == <!--T:1--> | |||

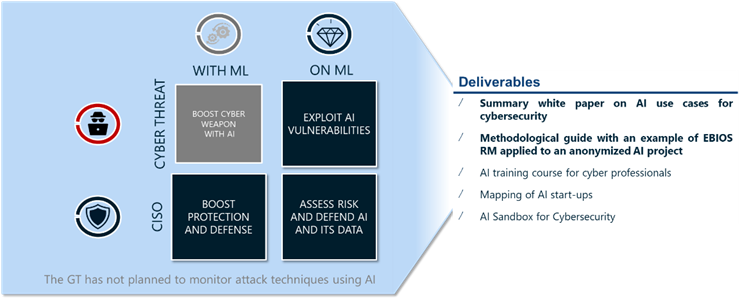

Le Groupe de Travail, lancé dans le cadre du Cycle 2 du Campus Cyber, a pour mission d'analyser les domaines dans lesquels la cybersécurité et l'intelligence artificielle se croisent. | |||

=== Objectifs initiaux === | === Objectifs initiaux === <!--T:2--> | ||

* Cataloguer les usages potentiels de l’IA pour la cybersécurité | |||

* Créer un environnement sandbox CYLVIA permettant aux membres du Campus Cyber d'expérimenter et d'évoluer dans un environnement restreint | |||

* Créer des parcours de formation à l’IA pour les professionnels de la cybersécurité à différents niveaux | |||

* Identifier les startups spécialisées en solutions IA pour la cybersécurité et en réaliser une cartographie | |||

* Identifier les cybermenaces et les mitigations possibles sur les systèmes d'application d'intelligence artificielle | |||

== | == La sécurité des systèmes intelligents et leurs utilisations en cybersécurité, état des connaissances et des compétences == <!--T:3--> | ||

[[Fichier:GT IA & Cyber - Focus du Groupe de Travail.png|vignette|300x300px|gauche]] | |||

Les systèmes d’Intelligence Artificielle sont de plus en plus répandus dans les technologies de l’information modernes et affichent de nombreuses avancées dans les dernières années. En vue de préparer les prochaines générations d’applications et de système de défense contre les cyber menaces, le Campus Cyber, au travers du Groupe de Travail Intelligence Artificielle et Cybersécurité, met en lumière les principaux usages de l’IA au bénéfice de la cybersécurité, les limites identifiées ainsi que les risques et principales mesures préconisées pour la sécurité de ces systèmes. | |||

== Quels acteurs impliqués dans les projets d'intelligence artificielle ? == | |||

[[Fichier: | |||

Les projets d’Intelligence Artificielle impliquent de nombreux acteurs afin de valoriser la donnée et de répondre au cas d’usages préalablement identifié. L’identification des ressources clés est un enjeu majeur pour tout expert en cybersécurité au démarrage d’un projet, une description succincte des rôles et responsabilité permet d’identifier rapidement les parties prenantes. Les différentes phases d’un projet IA, dont le développement, la mise en production et le suivi d’une application IA fait appel à de nombreux acteurs, dont certains sont spécialistes de data science et d’autres ne le sont pas. Le schéma ci-dessous présente les quatre grandes familles d’acteurs identifiés : | Les projets d’Intelligence Artificielle impliquent de nombreux acteurs afin de valoriser la donnée et de répondre au cas d’usages préalablement identifié. L’identification des ressources clés est un enjeu majeur pour tout expert en cybersécurité au démarrage d’un projet, une description succincte des rôles et responsabilité permet d’identifier rapidement les parties prenantes. Les différentes phases d’un projet IA, dont le développement, la mise en production et le suivi d’une application IA fait appel à de nombreux acteurs, dont certains sont spécialistes de data science et d’autres ne le sont pas. Le schéma ci-dessous présente les quatre grandes familles d’acteurs identifiés : | ||

* Les profils « métier », en charge du cas d’usage et de la validation de celui-ci par rapport aux objectifs de l’entreprise ; | * Les profils « métier », en charge du cas d’usage et de la validation de celui-ci par rapport aux objectifs de l’entreprise ; | ||

* Les spécialistes de data science, en charge de la mise en œuvre des techniques d’Intelligence Artificielle pour répondre aux besoins identifiés par les « métier » ; | * Les spécialistes de data science, en charge de la mise en œuvre des techniques d’Intelligence Artificielle pour répondre aux besoins identifiés par les « métier » ; | ||

* Les profils IT, en charge du développement et de la mise en production des cas d’usages conçus par les spécialistes de la data science ; | * Les profils IT, en charge du développement et de la mise en production des cas d’usages conçus par les spécialistes de la data science ; | ||

*Les profils « risque », en charge du contrôle et du respect des pratiques mises en œuvre par rapport aux politiques internes et réglementations externes. | * Les profils « risque », en charge du contrôle et du respect des pratiques mises en œuvre par rapport aux politiques internes et réglementations externes. | ||

<!--T:4--> | |||

Notons que chaque entreprise peut avoir des noms un peu différents pour ces profils, voire découper différemment les rôles sur différents acteurs. Les descriptions suivantes sont donc à adapter à chaque cas.Certains de ces profils sont transverses et interviennent sur de nombreux projets (sponsor métier, administrateur de plateforme de production, architecte données et profils risque) alors que d’autres sont dédiés à un projet et constituent une équipe projet. Les profils risque doivent donc intervenir aux côtés de profils IA dans des équipes projet mixtes. | |||

Le Groupe de Travail préconise également la création de deux postes complémentaires, les [[Référent sécurité en Intelligence Artificielle|référents sécurité en Intelligence Artificielle]] et les [[Facilitateur en Intelligence Artificielle|Facilitateurs en Intelligence Artificielle]]. | |||

== Quels apports de l'intelligence artificielle pour la cybersécurité ? == <!--T:5--> | |||

L’[[Apport de l'Intelligence Artificielle en cybersécurité|Intelligence Artificielle]], en tant que domaine scientifique, bénéficie de nombreuses avancées sur les dernières années, notamment grâce à la mise en commun de techniques, capacités et données permettant l’utilisation des approches statistiques du Machine Learning au détriment des approches déterministes des Systèmes Experts. Cette approche permet une généralisation et apporte des bénéfices lorsqu’un nombre significatif de données est mis en commun pour limiter les effets statistiques. De fait, les domaines de recherches en cybersécurité sont naturellement portés autours des axes suivants : | |||

* '''L’identification et la localisation des informations de l’entreprise,''' en commençant pas la classification de ces informations, et l’application de politiques dynamiques ; | |||

* '''La protection par l’analyse de signaux faibles et des comportements usuels,''' les systèmes à bas d’IA permettent de configurer les politiques et mécanismes de sécurité le plus efficacement possible ; | |||

* '''La détection en analysant la moindre variation des comportements et des changements réalisés sur les infrastructures''' afin de construire dynamiquement les scénarios de détection ; | |||

* '''La reprise via l’aide à la prise de décision,''' en ayant une connaissance fine du système d’information, permet d’établir la stratégie de réponse et de reprise associé à un incident de cybersécurité. | |||

* ''''' | |||

* ''''' | |||

<!--T:6--> | |||

Fort des enjeux et des expérimentations réalisées dans de nombreux contextes, le Groupe de Travail a identifié un ensemble de cas d’usages cybersécurité pouvant être accéléré ou augmenté par l’utilisation d’Intelligence Artificielle. Pour cela, un canevas a été défini pour classifier et enrichir les cas d’usages. | |||

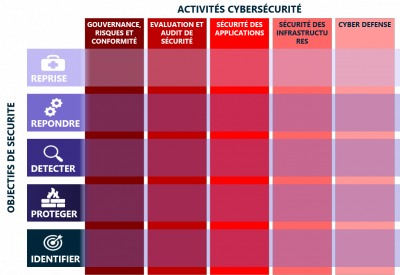

Ce Framework de classification des cas d’usages est une initiative du Groupe de Travail : il est basé sur les guides et standards du domaine et se veut « pratique » pour catégoriser simplement des cas d’usages et favoriser l’identification de nouveaux cas. En complément de l’aide à l’organisation des connaissances, ce framework a été conçu pour faciliter le partage avec des entités internationales. Il est construit autour de trois axes : | |||

[[Fichier:GT IA & Cyber - Framework de cas d'usages.png|vignette|400x400px|Framework des cas d'usages IA & Cybersécurité]] | |||

* la catégorisation des cas d'usages suivant les activités des équipes cybersécurité, en suivant un découpage typique d'une organisation cybersécurité; | |||

* ' | * la catégorisation du cas d’usage en fonction des objectifs de sécurité qu’il cherche à traiter. Le [https://www.nist.gov/cyberframework NIST Cybersecurity Framework] est ici utilisé ; | ||

* | * le rapprochement du cas d’usage avec le traitement d’attaque du [https://attack.mitre.org/ MITRE ATT&CK] ou la mise en œuvre d’éléments de défense du [https://d3fend.mitre.org/ MITRE D3FEND] | ||

* | ==== Activités cybersécurité ==== <!--T:7--> | ||

La catégorisation des cas d’usages par rapport aux activités des équipes cybersécurité a permis de constituer 5 grandes catégories : | |||

<!--T:8--> | |||

* La '''gestion des risques et de la conformité,''' incluant l’ensemble des activités de définition, traitement et gestion des risques et régulations applicables aux organisations ; | |||

<!--T:9--> | |||

* L’ '''évaluation de sécurité,''' souvent identifié au travail des « Red Teams », réalisant les activités d’audit, de tests d’intrusion, et de compromission de l’organisation ; | |||

<!--T:10--> | |||

* La '''sécurité applicative,''' intégrant les domaines de la gestion des identités et des accès, la mise sous protection des applications (Security by Design, SDLC, DevSecOps, etc.) ; | |||

* La '''sécurité des infrastructures,''' intégrant la mise en œuvre des solutions de cybersécurité d’infrastructure (FW, IPS, EDR, Proxy, Annuaires, etc.) nécessaires à la sécurité en profondeur des systèmes d’information ; | |||

* Les '''activités de cyberdéfense,''' souvent identifié au travail des « Blue Teams », assurant la sécurité opérationnelle des Systèmes d’Information des organisations. | |||

==== Objectifs de sécurité ==== | ==== Objectifs de sécurité ==== <!--T:11--> | ||

Les objectifs de sécurité visent à déterminer les activités à mettre en œuvre afin de maîtriser les risques de cybersécurité au sein des organisations, ceux-ci sont découpés en 5 types selon le framework du NIST : | Les objectifs de sécurité visent à déterminer les activités à mettre en œuvre afin de maîtriser les risques de cybersécurité au sein des organisations, ceux-ci sont découpés en 5 types selon le framework du NIST : | ||

: | |||

: | <!--T:12--> | ||

: | * '''IDENTIFIER''' ayant pour objectif l’identification, l’évaluation, et la mise en œuvre de l’organisation adaptée à la maîtrise du système d’information et au traitement des risques ; | ||

: | |||

: | <!--T:13--> | ||

* '''PROTÉGER''' ayant pour objectif de mettre en œuvre les activités nécessaires à la protection et au maintien en condition de sécurité des systèmes d’information ; | |||

<!--T:14--> | |||

* '''DÉTECTER''' ayant pour objectif d’identifier et de qualifier les incidents de cybersécurité ; | |||

<!--T:15--> | |||

* '''RÉPONDRE''' ayant pour objectif le traitement des incidents de cybersécurité : arrêt ou confinement de l’attaque, adaptation de la politique de sécurité ou de sa mise en œuvre ; | |||

<!--T:16--> | |||

* '''REPRISE''' ayant pour objectif de retourner à un état de fonctionnement normal suite à un incident de cybersécurité. | |||

==== Cas d’usages récences par les membres du Groupe de Travail Intelligence Artificielle et Cybersécurité ==== <!--T:17--> | |||

<!--T:18--> | |||

* [[Confidentiality Classification|Cas d'usage de Classification des données]] | |||

* [[Machine Learning contre DDoS|Cas d'usage d'utilisation du Machine Learning dans la mitigation d'attaque DDoS]] | |||

* [[Protection de la marque, lutte contre le typo-squatting|Cas d'usage de protection de la marque, lutte contre le typo-squatting]] | |||

* [[Détection de démissionnaires pressentis|Cas d'usage d'identification de démissionnaires pressentis]] | |||

* [[Détection d’événements de sécurité|Cas d'usage de User and Endpoint Behavior Analysis dans un SOC]] | |||

* [[Détection d’intrusions et de man-in-the middle dans les réseaux OT et IoT|Cas d'usage de détection de man-in-the middle dans les réseaux OT et IoT]] | |||

* [[User behavior anomaly detection|Cas d'usage de User Behavior Anomaly Detection pour les comptes compromis]] | |||

* [[Contrôler les élévations de privilèges irrégulières|Cas d'usage de contrôle des élévations de privilèges irrégulières]] | |||

* [[WIFI Pwnagotchi|Cas d'usage d'utilisation du pwnagotchi pour casser les WIFI]] | |||

== Quelles solutions pour sécuriser les applications utilisant des systèmes d'intelligence artificielles ? == <!--T:19--> | |||

==== Un système IA vu par les experts cybersécurité ==== <!--T:20--> | |||

nécessaire à la réalisation de tout projet IA, dans le cadre du Groupe de Travail, seules les briques communes ont été identifiées pour apporter une vision pragmatique et succinctes aux lecteurs. | |||

<!--T:21--> | |||

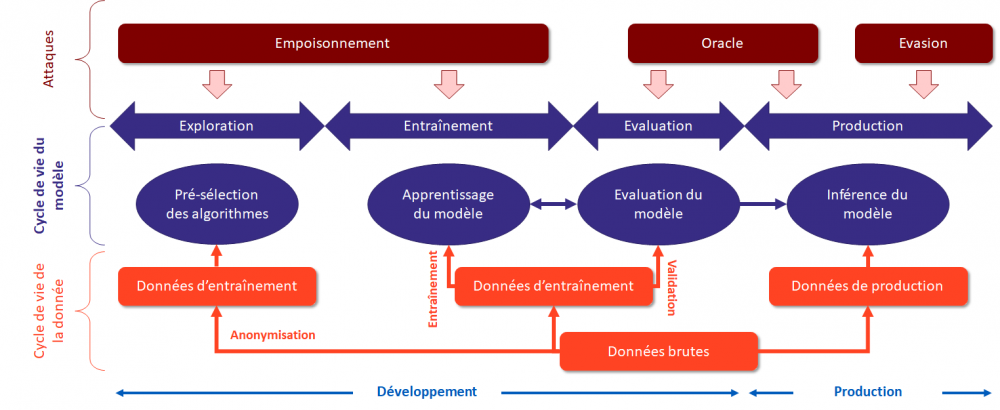

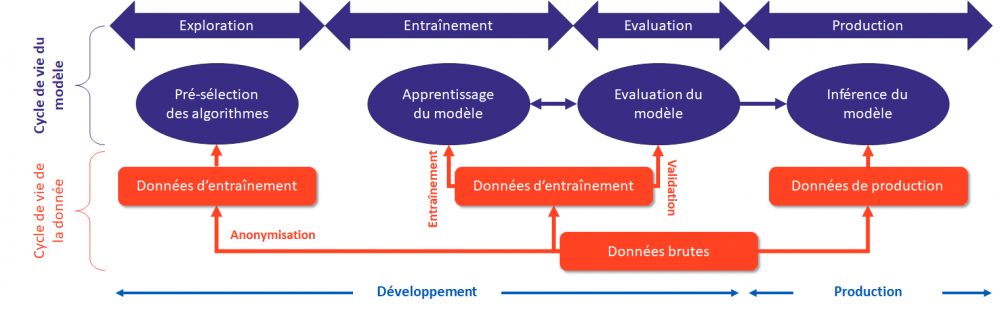

Un système d’Intelligence Artificielle peut être représenté suivant un pipeline composé de 4 étapes clés : | |||

[[Fichier:Modélisation d un systeme IA.png|centré|vignette|1000x1000px|Modélisation d'un pipeline d'Intelligence Artificielle]] | |||

<!--T:22--> | |||

* L'Exploration est un ensemble de composants techniques permettant d'analyser des données pour en comprendre le sens et déterminer les axes d'analyse des phases suivantes ; | |||

* L'Entraînement est un ensemble de composants techniques permettant de réaliser la modélisation des données et la réalisation de l'apprentissage d'un modèle d'IA ; | |||

* L'Evaluation est un ensemble de composants techniques permettant de valider la pertinence d'un modèle entraîné par rapport aux objectifs visés par la modélisation ; | |||

* La Production est un ensemble de composants techniques permettant au modèle d'inférer des résultats à partir de données de production. | |||

==== Appliquer EBIOS RM à un système d’Intelligence Artificielle ==== <!--T:23--> | |||

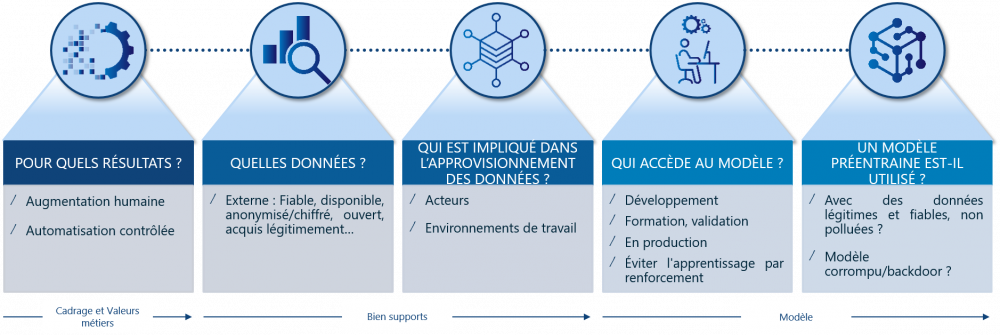

[[Fichier:GT IA & Cyber - Les questions à se poser.png|gauche|vignette|1000x1000px]] | |||

<!--T:24--> | |||

Les attaques contre le ML peuvent être regroupés en 3 grandes familles (empoisonnement, oracle et évasion) et couvrent l’ensemble de cycle de vie d’un système à base de ML. | |||

<!--T:25--> | |||

[[Fichier:Attaques sur un systeme IA.png|sans_cadre|1000x1000px]] | |||

<!--T:26--> | |||

Les recherches du groupe de travail ont identifié différents 5 schémas d’attaques applicable à tout système d’Intelligence Artificielle : | |||

<!--T:27--> | |||

* Attaque par empoisonnement des données d’entrainement (ciblé ou non) | |||

* Attaque sur la chaîne d’approvisionnement des données – ''data supply'' | |||

* Attaque sur la chaîne d’approvisionnement des bibliothèques – ''library supply'' | |||

* Attaque par oracle sur le modèle en production | |||

* Attaque par évasion sur le modèle en production | |||

==== Des solutions concrètes permettent de réduire les risques de compromission des systèmes ==== <!--T:28--> | |||

Les 4 bonnes pratiques à mettre en place pour limiter les risques liés aux systèmes IA sont : | |||

<!--T:29--> | |||

* Mettre en œuvre un comité éthique et risques pour sélectionner les cas d’usages intelligence artificielle pertinents pour l’entreprise et les données autorisées | |||

* Informer les équipes intelligence artificielle et Data de leurs droits et devoirs pour manipuler les données et les risques associés | |||

* Former les équipes intelligence artificielle et Data aux bonnes pratiques de manipulation sécurisée de la donnée (anonymisation, chiffrement…), aux techniques d’apprentissage distribué et au développement sécurisé | |||

* Définir sur chaque projet : les données ne pouvant pas être transmises au système, les limites de déviation/pertinence du système acceptables et les signaux de vol de donnée (volume de requête, interrogation ciblée sur une donnée critique…) | |||

<!--T:30--> | |||

Des mesures spécifiques aux environnements de développement, d’entraînement, de validation et de production : | |||

<!--T:31--> | |||

* Standardiser l’anonymisation de la collecte des données, le chiffrement de leur stockage et de leur transmission | |||

* Mettre en œuvre des scénarios de détection des fuites d’information pour l’ensemble du pipeline data | |||

* Prévoir un environnement d’entraînement spécifique et isolé avec un accès restreint aux librairies pour ceux qui manipulent les jeux de données | |||

* Valider régulièrement le niveau de sécurité des librairies et composants open-sources utilisés dans les environnements d’entraînement et de validation | |||

* Construire des ''datasets'' adverses avec les scénarios de risques identifiés pour valider les changements sur les modèles | |||

* Lancer les modèles en production dans des enclaves sécurisées ayant des droits d’exécution limités | |||

* Surveiller les systèmes pour détecter les déviations | |||

</translate> | |||

{{PageSubHeader Groupe de travail | |||

|UseCase=Confidentiality Classification# Contrôler les élévations de privilèges irrégulières# Détection de démissionnaires pressentis# Détection d’intrusions et de man-in-the middle dans les réseaux OT et IoT# Détection d’événements de sécurité# Machine Learning contre DDoS# User behavior anomaly detection# WIFI Pwnagotchi# Protection de la marque, lutte contre le typo-squatting | |||

|Communauté d'intérêt=CI IA et Cybersécurité | |||

}} | |||

Dernière version du 12 février 2025 à 16:19

Analyser les domaines de la cybersécurité où l’Intelligence Artificielle permet des avancées

Catégorie : Groupe de travail Cycle : Cycle 2 Statut : Terminé

Date de début : mai 2021

Date de fin : décembre 2023

Objectifs et livrables du Groupe de Travail

Le Groupe de Travail, lancé dans le cadre du Cycle 2 du Campus Cyber, a pour mission d'analyser les domaines dans lesquels la cybersécurité et l'intelligence artificielle se croisent.

Objectifs initiaux

- Cataloguer les usages potentiels de l’IA pour la cybersécurité

- Créer un environnement sandbox CYLVIA permettant aux membres du Campus Cyber d'expérimenter et d'évoluer dans un environnement restreint

- Créer des parcours de formation à l’IA pour les professionnels de la cybersécurité à différents niveaux

- Identifier les startups spécialisées en solutions IA pour la cybersécurité et en réaliser une cartographie

- Identifier les cybermenaces et les mitigations possibles sur les systèmes d'application d'intelligence artificielle

La sécurité des systèmes intelligents et leurs utilisations en cybersécurité, état des connaissances et des compétences

Les systèmes d’Intelligence Artificielle sont de plus en plus répandus dans les technologies de l’information modernes et affichent de nombreuses avancées dans les dernières années. En vue de préparer les prochaines générations d’applications et de système de défense contre les cyber menaces, le Campus Cyber, au travers du Groupe de Travail Intelligence Artificielle et Cybersécurité, met en lumière les principaux usages de l’IA au bénéfice de la cybersécurité, les limites identifiées ainsi que les risques et principales mesures préconisées pour la sécurité de ces systèmes.

Quels acteurs impliqués dans les projets d'intelligence artificielle ?

Les projets d’Intelligence Artificielle impliquent de nombreux acteurs afin de valoriser la donnée et de répondre au cas d’usages préalablement identifié. L’identification des ressources clés est un enjeu majeur pour tout expert en cybersécurité au démarrage d’un projet, une description succincte des rôles et responsabilité permet d’identifier rapidement les parties prenantes. Les différentes phases d’un projet IA, dont le développement, la mise en production et le suivi d’une application IA fait appel à de nombreux acteurs, dont certains sont spécialistes de data science et d’autres ne le sont pas. Le schéma ci-dessous présente les quatre grandes familles d’acteurs identifiés :

- Les profils « métier », en charge du cas d’usage et de la validation de celui-ci par rapport aux objectifs de l’entreprise ;

- Les spécialistes de data science, en charge de la mise en œuvre des techniques d’Intelligence Artificielle pour répondre aux besoins identifiés par les « métier » ;

- Les profils IT, en charge du développement et de la mise en production des cas d’usages conçus par les spécialistes de la data science ;

- Les profils « risque », en charge du contrôle et du respect des pratiques mises en œuvre par rapport aux politiques internes et réglementations externes.

Notons que chaque entreprise peut avoir des noms un peu différents pour ces profils, voire découper différemment les rôles sur différents acteurs. Les descriptions suivantes sont donc à adapter à chaque cas.Certains de ces profils sont transverses et interviennent sur de nombreux projets (sponsor métier, administrateur de plateforme de production, architecte données et profils risque) alors que d’autres sont dédiés à un projet et constituent une équipe projet. Les profils risque doivent donc intervenir aux côtés de profils IA dans des équipes projet mixtes.

Le Groupe de Travail préconise également la création de deux postes complémentaires, les référents sécurité en Intelligence Artificielle et les Facilitateurs en Intelligence Artificielle.

Quels apports de l'intelligence artificielle pour la cybersécurité ?

L’Intelligence Artificielle, en tant que domaine scientifique, bénéficie de nombreuses avancées sur les dernières années, notamment grâce à la mise en commun de techniques, capacités et données permettant l’utilisation des approches statistiques du Machine Learning au détriment des approches déterministes des Systèmes Experts. Cette approche permet une généralisation et apporte des bénéfices lorsqu’un nombre significatif de données est mis en commun pour limiter les effets statistiques. De fait, les domaines de recherches en cybersécurité sont naturellement portés autours des axes suivants :

- L’identification et la localisation des informations de l’entreprise, en commençant pas la classification de ces informations, et l’application de politiques dynamiques ;

- La protection par l’analyse de signaux faibles et des comportements usuels, les systèmes à bas d’IA permettent de configurer les politiques et mécanismes de sécurité le plus efficacement possible ;

- La détection en analysant la moindre variation des comportements et des changements réalisés sur les infrastructures afin de construire dynamiquement les scénarios de détection ;

- La reprise via l’aide à la prise de décision, en ayant une connaissance fine du système d’information, permet d’établir la stratégie de réponse et de reprise associé à un incident de cybersécurité.

Fort des enjeux et des expérimentations réalisées dans de nombreux contextes, le Groupe de Travail a identifié un ensemble de cas d’usages cybersécurité pouvant être accéléré ou augmenté par l’utilisation d’Intelligence Artificielle. Pour cela, un canevas a été défini pour classifier et enrichir les cas d’usages.

Ce Framework de classification des cas d’usages est une initiative du Groupe de Travail : il est basé sur les guides et standards du domaine et se veut « pratique » pour catégoriser simplement des cas d’usages et favoriser l’identification de nouveaux cas. En complément de l’aide à l’organisation des connaissances, ce framework a été conçu pour faciliter le partage avec des entités internationales. Il est construit autour de trois axes :

- la catégorisation des cas d'usages suivant les activités des équipes cybersécurité, en suivant un découpage typique d'une organisation cybersécurité;

- la catégorisation du cas d’usage en fonction des objectifs de sécurité qu’il cherche à traiter. Le NIST Cybersecurity Framework est ici utilisé ;

- le rapprochement du cas d’usage avec le traitement d’attaque du MITRE ATT&CK ou la mise en œuvre d’éléments de défense du MITRE D3FEND

Activités cybersécurité

La catégorisation des cas d’usages par rapport aux activités des équipes cybersécurité a permis de constituer 5 grandes catégories :

- La gestion des risques et de la conformité, incluant l’ensemble des activités de définition, traitement et gestion des risques et régulations applicables aux organisations ;

- L’ évaluation de sécurité, souvent identifié au travail des « Red Teams », réalisant les activités d’audit, de tests d’intrusion, et de compromission de l’organisation ;

- La sécurité applicative, intégrant les domaines de la gestion des identités et des accès, la mise sous protection des applications (Security by Design, SDLC, DevSecOps, etc.) ;

- La sécurité des infrastructures, intégrant la mise en œuvre des solutions de cybersécurité d’infrastructure (FW, IPS, EDR, Proxy, Annuaires, etc.) nécessaires à la sécurité en profondeur des systèmes d’information ;

- Les activités de cyberdéfense, souvent identifié au travail des « Blue Teams », assurant la sécurité opérationnelle des Systèmes d’Information des organisations.

Objectifs de sécurité

Les objectifs de sécurité visent à déterminer les activités à mettre en œuvre afin de maîtriser les risques de cybersécurité au sein des organisations, ceux-ci sont découpés en 5 types selon le framework du NIST :

- IDENTIFIER ayant pour objectif l’identification, l’évaluation, et la mise en œuvre de l’organisation adaptée à la maîtrise du système d’information et au traitement des risques ;

- PROTÉGER ayant pour objectif de mettre en œuvre les activités nécessaires à la protection et au maintien en condition de sécurité des systèmes d’information ;

- DÉTECTER ayant pour objectif d’identifier et de qualifier les incidents de cybersécurité ;

- RÉPONDRE ayant pour objectif le traitement des incidents de cybersécurité : arrêt ou confinement de l’attaque, adaptation de la politique de sécurité ou de sa mise en œuvre ;

- REPRISE ayant pour objectif de retourner à un état de fonctionnement normal suite à un incident de cybersécurité.

Cas d’usages récences par les membres du Groupe de Travail Intelligence Artificielle et Cybersécurité

- Cas d'usage de Classification des données

- Cas d'usage d'utilisation du Machine Learning dans la mitigation d'attaque DDoS

- Cas d'usage de protection de la marque, lutte contre le typo-squatting

- Cas d'usage d'identification de démissionnaires pressentis

- Cas d'usage de User and Endpoint Behavior Analysis dans un SOC

- Cas d'usage de détection de man-in-the middle dans les réseaux OT et IoT

- Cas d'usage de User Behavior Anomaly Detection pour les comptes compromis

- Cas d'usage de contrôle des élévations de privilèges irrégulières

- Cas d'usage d'utilisation du pwnagotchi pour casser les WIFI

Quelles solutions pour sécuriser les applications utilisant des systèmes d'intelligence artificielles ?

Un système IA vu par les experts cybersécurité

nécessaire à la réalisation de tout projet IA, dans le cadre du Groupe de Travail, seules les briques communes ont été identifiées pour apporter une vision pragmatique et succinctes aux lecteurs.

Un système d’Intelligence Artificielle peut être représenté suivant un pipeline composé de 4 étapes clés :

- L'Exploration est un ensemble de composants techniques permettant d'analyser des données pour en comprendre le sens et déterminer les axes d'analyse des phases suivantes ;

- L'Entraînement est un ensemble de composants techniques permettant de réaliser la modélisation des données et la réalisation de l'apprentissage d'un modèle d'IA ;

- L'Evaluation est un ensemble de composants techniques permettant de valider la pertinence d'un modèle entraîné par rapport aux objectifs visés par la modélisation ;

- La Production est un ensemble de composants techniques permettant au modèle d'inférer des résultats à partir de données de production.

Appliquer EBIOS RM à un système d’Intelligence Artificielle

Les attaques contre le ML peuvent être regroupés en 3 grandes familles (empoisonnement, oracle et évasion) et couvrent l’ensemble de cycle de vie d’un système à base de ML.

Les recherches du groupe de travail ont identifié différents 5 schémas d’attaques applicable à tout système d’Intelligence Artificielle :

- Attaque par empoisonnement des données d’entrainement (ciblé ou non)

- Attaque sur la chaîne d’approvisionnement des données – data supply

- Attaque sur la chaîne d’approvisionnement des bibliothèques – library supply

- Attaque par oracle sur le modèle en production

- Attaque par évasion sur le modèle en production

Des solutions concrètes permettent de réduire les risques de compromission des systèmes

Les 4 bonnes pratiques à mettre en place pour limiter les risques liés aux systèmes IA sont :

- Mettre en œuvre un comité éthique et risques pour sélectionner les cas d’usages intelligence artificielle pertinents pour l’entreprise et les données autorisées

- Informer les équipes intelligence artificielle et Data de leurs droits et devoirs pour manipuler les données et les risques associés

- Former les équipes intelligence artificielle et Data aux bonnes pratiques de manipulation sécurisée de la donnée (anonymisation, chiffrement…), aux techniques d’apprentissage distribué et au développement sécurisé

- Définir sur chaque projet : les données ne pouvant pas être transmises au système, les limites de déviation/pertinence du système acceptables et les signaux de vol de donnée (volume de requête, interrogation ciblée sur une donnée critique…)

Des mesures spécifiques aux environnements de développement, d’entraînement, de validation et de production :

- Standardiser l’anonymisation de la collecte des données, le chiffrement de leur stockage et de leur transmission

- Mettre en œuvre des scénarios de détection des fuites d’information pour l’ensemble du pipeline data

- Prévoir un environnement d’entraînement spécifique et isolé avec un accès restreint aux librairies pour ceux qui manipulent les jeux de données

- Valider régulièrement le niveau de sécurité des librairies et composants open-sources utilisés dans les environnements d’entraînement et de validation

- Construire des datasets adverses avec les scénarios de risques identifiés pour valider les changements sur les modèles

- Lancer les modèles en production dans des enclaves sécurisées ayant des droits d’exécution limités

- Surveiller les systèmes pour détecter les déviations

Porté par la communauté

CI IA et Cybersécurité (Analyser les domaines de la cybersécurité où l’Intelligence Artificielle permet des avancées)

Communs

| Analyse des attaques sur les systèmes de l'IA | Production du livrable "Analyse des attaques sur les systèmes de l'IA" dans le cadre de la Communauté d'Intérêt Sécurité de l'IA co-piloté par le Campus Cyber et le Hub France IA |

| Appliquer EBIOS RM à un système IA | Application du guide « méthodologie EBIOS RM » publié par l’ANSSI pour évaluer un système à base d’intelligence artificielle. |

| Cas d'usage IA et Cybersécurité | Le groupe de travail IA et cybersécurité a identifié plusieurs cas d'usages, listés ci-dessous. |

| Facilitateur en Intelligence Artificielle | Un facilitateur IA est un correspondant cyber disposant de connaissances pratiques en cybersécurité et en Intelligence Artificielle. |

| L'intelligence artificielle en cybersécurité | Identifie et analyse certains cas d'usage où l’Intelligence Artificielle permet des avancées pour la cybersécurité. |

| Référent sécurité en Intelligence Artificielle | Le référent cybersécurité pour les data scientists est intégré dans leur environnement de travail. Il est leur point de contact privilégié pour assurer concrètement la prise en compte de la cybersécurité dans les projets IA qu’ils développent. |

| Réglementation de l'IA | Synthèse de la règlemention européen dite « Artificial Intelligence Act ». |

| UC3 : Brand protection, fight against typo-squatting | Développement du Use Case pédagogique "UC 3 : Lutte contre le typosquatting" dans le cadre du GT IA et Cyber |

| UC5 : Machine Learning vs DDoS | Développement du Use Case pédagogique "Machine Learning vs Attaque DDoS" dans le cadre du GT IA et Cyber |

| UC7 : Suspicious security events detection | Développement du Use Case pédagogique "Suspicious security events detection" dans le cadre du GT IA et Cyber |

Cas d'usage

| Statut | ||

|---|---|---|

| Confidentiality Classification | ||

| Lutte contre le typo-squatting |